Comparación de modelos de pago de Github Copilot

Categories:

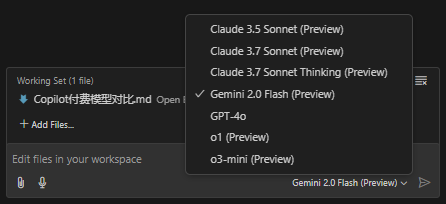

Github Copilot actualmente ofrece 7 modelos:

- Claude 3.5 Sonnet

- Claude 3.7 Sonnet

- Claude 3.7 Sonnet Thinking

- Gemini 2.0 Flash

- GPT-4o

- o1

- o3-mini

Falta una introducción oficial de estos 7 modelos. Este artículo describe brevemente sus puntuaciones en diversos campos para distinguir sus áreas de especialidad y facilitar a los lectores cambiar al modelo más adecuado al abordar problemas específicos.

Comparación de modelos

Tabla comparativa multidimensional basada en datos de evaluaciones públicas (parte de los datos son estimaciones y conversiones de diferentes fuentes), que abarca tres indicadores clave: codificación (SWE‑Bench Verified), matemáticas (AIME’24) y razonamiento (GPQA Diamond):

| Modelo | Desempeño en codificación (SWE‑Bench Verified) |

Desempeño en matemáticas (AIME'24) |

Desempeño en razonamiento (GPQA Diamond) |

|---|---|---|---|

| Claude 3.5 Sonnet | 70.3% | 49.0% | 77.0% |

| Claude 3.7 Sonnet (modo estándar) | ≈83.7% (aumento ≈19%) |

≈58.3% (aumento ≈19%) |

≈91.6% (aumento ≈19%) |

| Claude 3.7 Sonnet Thinking | ≈83.7% (similar al estándar) |

≈64.0% (mejora adicional en modo pensamiento) |

≈95.0% (mayor capacidad de razonamiento) |

| Gemini 2.0 Flash | ≈65.0% (estimado) |

≈45.0% (estimado) |

≈75.0% (estimado) |

| GPT‑4o | 38.0% | 36.7% | 71.4% |

| o1 | 48.9% | 83.3% | 78.0% |

| o3‑mini | 49.3% | 87.3% | 79.7% |

Notas:

- Los valores de la tabla provienen de algunas evaluaciones públicas (por ejemplo, el informe comparativo de la plataforma Vellum VELLUM.AI) y algunas conversiones de datos (por ejemplo, Claude 3.7 mejora aproximadamente un 19% frente a 3.5). Algunos valores de Gemini 2.0 Flash son estimaciones.

- “Claude 3.7 Sonnet Thinking” se refiere al modo en que se activa el “modo pensamiento” (es decir, se extienden los pasos internos de razonamiento), mejorando significativamente el desempeño del modelo en tareas matemáticas y de razonamiento.

Resumen de fortalezas y debilidades y áreas de aplicación

Serie Claude (3.5/3.7 Sonnet y sus variantes Thinking)

- Fortalezas: Alta precisión en codificación y tareas de razonamiento en múltiples pasos, especialmente en la versión 3.7, que muestra una mejora notable frente a 3.5; En modo “Thinking”, el desempeño en matemáticas y razonamiento es mejor, adecuado para tareas complejas de lógica o que requieren planificación detallada; Ventajas integradas en llamadas a herramientas y manejo de contextos largos.

- Debilidades: En modo estándar, los indicadores matemáticos son relativamente bajos, solo mejoran significativamente al activar el razonamiento extendido; El costo y el tiempo de respuesta pueden ser más altos en algunos escenarios. Áreas de aplicación: Ingeniería de software, generación y depuración de código, resolución de problemas complejos, toma de decisiones en múltiples pasos y flujos de trabajo de automatización empresarial.

Gemini 2.0 Flash

- Fortalezas: Cuenta con una gran ventana de contexto, adecuada para el procesamiento de documentos largos y entradas multimodales (por ejemplo, análisis de imágenes); La capacidad de razonamiento y la codificación muestran un buen desempeño en algunas pruebas, con una velocidad de respuesta rápida.

- Debilidades: En algunos escenarios (como tareas de codificación complejas) puede presentar fenómenos de “bloqueo”, y la estabilidad aún necesita verificación; Algunos indicadores son estimaciones preliminares, y el desempeño general aún requiere más datos públicos para confirmación. Áreas de aplicación: Tareas multimodales, interacciones en tiempo real y escenarios que requieren un gran contexto, como resumen de documentos largos, análisis de video y recuperación de información.

GPT‑4o

- Fortalezas: Comprensión y generación de lenguaje natural fluida, ideal para diálogos abiertos y procesamiento general de texto.

- Debilidades: El desempeño en tareas profesionales como codificación y matemáticas es relativamente débil, con algunos indicadores muy por debajo de los de la competencia; Costo alto (similar al GPT‑4.5), con menor relación calidad-precio frente a algunos competidores. Áreas de aplicación: Sistemas de diálogo general, creación de contenido, redacción de textos y tareas de preguntas y respuestas diarias.

o1 y o3‑mini (serie OpenAI)

- Fortalezas: Excelente en razonamiento matemático, con o1 y o3‑mini alcanzando 83.3% y 87.3% respectivamente en tareas tipo AIME; Capacidad de razonamiento estable, adecuada para aplicaciones que requieren análisis matemático y lógico de alta precisión.

- Debilidades: Desempeño de codificación medio, ligeramente inferior a la serie Claude; El rendimiento general muestra cierto desequilibrio en diferentes tareas. Áreas de aplicación: Cálculo científico, resolución de problemas matemáticos, razonamiento lógico, tutoría educativa y análisis de datos profesionales.