Confronto dei modelli a pagamento di Github Copilot

Categories:

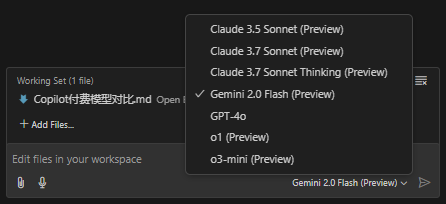

Github Copilot attualmente offre 7 modelli:

- Claude 3.5 Sonnet

- Claude 3.7 Sonnet

- Claude 3.7 Sonnet Thinking

- Gemini 2.0 Flash

- GPT-4o

- o1

- o3-mini

La documentazione ufficiale manca di una descrizione di questi 7 modelli. Questo articolo descrive brevemente i punteggi di ciascuno in diversi domini, per distinguere le loro aree di competenza e consentire ai lettori di passare al modello più adatto quando si affrontano problemi specifici.

Confronto tra modelli

Tabella comparativa multidimensionale basata su dati di benchmark pubblici (alcuni dati sono stime o conversioni da fonti diverse), che copre tre indicatori chiave: codifica (SWE‑Bench Verified), matematica (AIME'24) e ragionamento (GPQA Diamond):

| Modello | Prestazioni di codifica (SWE‑Bench Verified) |

Prestazioni matematiche (AIME'24) |

Prestazioni di ragionamento (GPQA Diamond) |

|---|---|---|---|

| Claude 3.5 Sonnet | 70.3% | 49.0% | 77.0% |

| Claude 3.7 Sonnet (modalità standard) | ≈83.7% (aumento ≈19%) |

≈58.3% (aumento ≈19%) |

≈91.6% (aumento ≈19%) |

| Claude 3.7 Sonnet Thinking | ≈83.7% (simile alla versione standard) |

≈64.0% (ulteriore miglioramento in modalità pensiero) |

≈95.0% (capacità di ragionamento migliore) |

| Gemini 2.0 Flash | ≈65.0% (stima) |

≈45.0% (stima) |

≈75.0% (stima) |

| GPT‑4o | 38.0% | 36.7% | 71.4% |

| o1 | 48.9% | 83.3% | 78.0% |

| o3‑mini | 49.3% | 87.3% | 79.7% |

Note:

- I valori della tabella sono tratti da alcuni benchmark pubblici (ad esempio il rapporto comparativo della piattaforma Vellum su VELLUM.AI) e da alcune conversioni di dati (ad esempio il miglioramento di Claude 3.7 rispetto al 3.5 è di circa il 19%). Alcuni valori di Gemini 2.0 Flash sono stime.

- “Claude 3.7 Sonnet Thinking” indica il modello in modalità “pensiero” (cioè con passaggi di ragionamento interni prolungati), in cui le prestazioni in matematica e ragionamento migliorano significativamente.

Riassunto di punti di forza e debolezza e campi di applicazione

Serie Claude (3.5/3.7 Sonnet e le loro varianti Thinking)

- Punti di forza: Alta accuratezza nei compiti di codifica e ragionamento a più passi, specialmente nella versione 3.7 che mostra un miglioramento significativo rispetto al 3.5; La modalità “Thinking” migliora notevolmente le prestazioni in matematica e ragionamento, adatta a compiti complessi o che richiedono piani dettagliati; Vantaggi integrati nel richiamo di strumenti e nella gestione di contesti lunghi.

- Punti di debolezza: Nella modalità standard le metriche matematiche sono relativamente basse, migliorando solo con ragionamento prolungato; Costi e tempi di risposta possono essere più elevati in alcuni scenari. Campi di applicazione: Ingegneria del software, generazione e debug di codice, risoluzione di problemi complessi, decisioni a più passi e flussi di lavoro automatizzati aziendali.

Gemini 2.0 Flash

- Punti di forza: Ampia finestra di contesto, adatta all’elaborazione di documenti lunghi e input multimodali (ad esempio analisi di immagini); Capacità di ragionamento e prestazioni di codifica soddisfacenti in alcuni test, con tempi di risposta rapidi.

- Punti di debolezza: In alcuni scenari (ad esempio compiti di codifica complessi) può verificarsi il fenomeno di “blocco”, la stabilità necessita di ulteriore verifica; Alcune metriche sono stime preliminari, le prestazioni complessive richiedono più dati pubblici per essere confermate. Campi di applicazione: Compiti multimodali, interazione in tempo reale, applicazioni che necessitano di contesti ampi, come sommari di documenti lunghi, analisi video e recupero informazioni.

GPT‑4o

- Punti di forza: Comprensione e generazione del linguaggio naturali e fluenti, adatti al dialogo aperto e all’elaborazione testuale generale.

- Punti di debolezza: Prestazioni relativamente scarse nei compiti professionali come codifica e matematica, con alcune metriche ben al di sotto di modelli concorrenti; Costi elevati (simili a GPT‑4.5), rapporto costo-prestazioni inferiore rispetto ad alcuni concorrenti. Campi di applicazione: Sistemi di dialogo generale, creazione di contenuti, scrittura di testi e compiti di domande e risposte quotidiane.

o1 e o3‑mini (serie OpenAI)

- Punti di forza: Eccellenti capacità di ragionamento matematico, con o1 e o3‑mini che raggiungono rispettivamente l'83.3% e l'87.3% nei compiti tipo AIME; Capacità di ragionamento stabile, adatta ad applicazioni che richiedono analisi matematiche e logiche ad alta precisione.

- Punti di debolezza: Prestazioni di codifica medie, leggermente inferiori rispetto alla serie Claude; Prestazioni generali leggermente sbilanciate tra diversi compiti. Campi di applicazione: Calcolo scientifico, risoluzione di problemi matematici, ragionamento logico, tutoraggio educativo e analisi dati professionali.