Github Copilot付費模型對比

Categories:

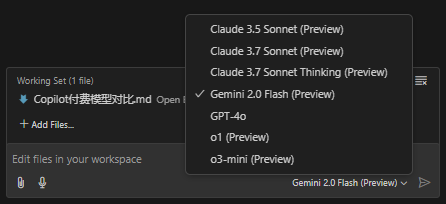

Github Copilot 目前提供了 7 種模型,

- Claude 3.5 Sonnet

- Claude 3.7 Sonnet

- Claude 3.7 Sonnet Thinking

- Gemini 2.0 Flash

- GPT-4o

- o1

- o3-mini

官方缺少對這 7 種模型的介紹, 本文簡略的描述它們在各領域的評分, 以區分它們擅長的領域, 方便讀者在處理特定問題時, 切換到更合適的模型.

模型對比

基於公開評測數據(部分數據為估算與不同來源折算後得出)的多維度對比表,涵蓋編碼(SWE‑Bench Verified)、數學(AIME’24)和推理(GPQA Diamond)三個關鍵指標:

| 模型 | 編碼表現 (SWE‑Bench Verified) |

數學表現 (AIME'24) |

推理表現 (GPQA Diamond) |

|---|---|---|---|

| Claude 3.5 Sonnet | 70.3% | 49.0% | 77.0% |

| Claude 3.7 Sonnet (標準模式) | ≈83.7% (提高 ≈19%) |

≈58.3% (提高 ≈19%) |

≈91.6% (提高 ≈19%) |

| Claude 3.7 Sonnet Thinking | ≈83.7% (與標準相近) |

≈64.0% (思考模式進一步提升) |

≈95.0% (更強推理能力) |

| Gemini 2.0 Flash | ≈65.0% (估算) |

≈45.0% (估算) |

≈75.0% (估算) |

| GPT‑4o | 38.0% | 36.7% | 71.4% |

| o1 | 48.9% | 83.3% | 78.0% |

| o3‑mini | 49.3% | 87.3% | 79.7% |

說明:

- 上表數值取自部分公開評測(例如 Vellum 平台的對比報告 VELLUM.AI)以及部分數據折算(例如 Claude 3.7 相比 3.5 大約提升 19%),部分 Gemini 2.0 Flash 數值為估算值。

- “Claude 3.7 Sonnet Thinking”指的是在開啟“思考模式”(即延長內部推理步驟)的情況下,模型在數學與推理任務上的表現顯著改善。

優劣勢總結與應用領域

Claude 系列(3.5/3.7 Sonnet 與其 Thinking 變體)

- 優勢: 在編碼和多步推理任務上具有較高準確率,尤其是 3.7 版本較 3.5 有明顯提升; “Thinking”模式下數學和推理表現更佳,適合處理複雜邏輯或需要詳細計劃的任務; 內置對工具調用和長上下文處理有優勢。

- 劣勢: 標準模式下數學指標相對較低,只有在開啟延長推理時才能顯著改善; 成本和響應時長在某些場景下可能較高。 適用領域: 軟體工程、程式碼生成與偵錯、複雜問題求解、多步決策及企業級自動化工作流程。

Gemini 2.0 Flash

- 優勢: 具備較大上下文窗口,適合長文件處理與多模態輸入(例如圖像解析); 推理能力與編碼表現在部分測試中表現不俗,且響應速度快。

- 劣勢: 部分場景下(如複雜編碼任務)可能會出現“卡住”現象,穩定性有待驗證; 部分指標為初步估算,整體表現仍需更多公開數據確認。 適用領域: 多模態任務、即時互動、需要大上下文的應用場景,如長文件摘要、影片解析及資訊檢索。

GPT‑4o

- 優勢: 語言理解和生成自然流暢,適合開放性對話和一般文本處理。

- 劣勢: 在編碼、數學等專業任務上的表現相對較弱,部分指標遠低於同類模型; 成本較高(與 GPT‑4.5 類似),性價比不如部分競爭對手。 適用領域: 通用對話系統、內容創作、文案撰寫及日常問答任務。

o1 與 o3‑mini(OpenAI 系列)

- 優勢: 數學推理方面表現出色,o1 與 o3‑mini 在 AIME 類任務上分別達到 83.3% 和 87.3%; 推理能力較穩定,適合需要高精度數學和邏輯分析的應用。

- 劣勢: 編碼表現中等,相較於 Claude 系列稍遜一籌; 整體性能在不同任務上表現略有不平衡。 適用領域: 科學計算、數學問題求解、邏輯推理、教育輔導及專業數據分析領域。